生成扩散模型漫谈(十三):从万有引力到扩散模型

By 苏剑林 | 2022-10-18 | 40848位读者 | 引用对于很多读者来说,生成扩散模型可能是他们遇到的第一个能够将如此多的数学工具用到深度学习上的模型。在这个系列文章中,我们已经展示了扩散模型与数学分析、概率统计、常微分方程、随机微分方程乃至偏微分方程等内容的深刻联系,可以说,即便是做数学物理方程的纯理论研究的同学,大概率也可以在扩散模型中找到自己的用武之地。

在这篇文章中,我们再介绍一个同样与数学物理有深刻联系的扩散模型——由“万有引力定律”启发的ODE式扩散模型,出自论文《Poisson Flow Generative Models》(简称PFGM),它给出了一个构建ODE式扩散模型的全新视角。

万有引力

中学时期我们就学过万有引力定律,大概的描述方式是:

两个质点彼此之间相互吸引的作用力,是与它们的质量乘积成正比,并与它们之间的距离成平方反比。

《自然极值》系列——1.前言

By 苏剑林 | 2010-11-27 | 46991位读者 | 引用附:期中考过后,课程紧了,自由时间少了,因此科学空间的更新也放缓了。不过BoJone也会尽量地更新一些内容,和大家一同分享学习的乐趣。

上一周和这一周的时间里,BoJone将自己学习物理和极值的一些内容进行了总结和整合,写成了《自然极值》一文。因此从今天起,到十二月的大多数时间里,科学空间将和大家讲述并讨论关于“极值”的问题,希望读者会喜欢这部分内容。当然,我不是专业的研究人员,更不是经验丰富的物理和数学教师,甚至可以说是一个“乳臭未干的小子”,因此,错误在所难免,只希望同好不吝指出,更希冀能够起到我抛出的这一块“砖”能够引出美妙的“玉”。

《自然极值》系列——3.平衡态公理

By 苏剑林 | 2010-11-28 | 17017位读者 | 引用光学定律无疑是一个美妙的原理,而自然界中还存在另外一个我们随处可见的“公理”。平时的生活中,我们总能看见“水往低处流”的现象,这是因为水处于地球重力场的结果(也正因为如此,某些轻生者的自杀活动才得以顺利进行;当然,我们并不需要为了验证这一点而亲自试验。)。由此我们可以联想到一个名词:重力势能。“水往低处流”意味着什么呢?高度变低了。高度更低意味着什么呢?重力势能降低了!换句话说,自然界中物体有趋于势能最低的倾向。我们可以从这个角度来解释:体系总有趋于稳定的倾向,而拥有的能量(势能)越高,则越不稳定。

《自然极值》系列——5.最速降线的故事

By 苏剑林 | 2010-12-09 | 62455位读者 | 引用如果说前面关于这个系列的内容还不能使得读者您感到痛快,那么接下来要讲述的最速降线和悬链线问题也许能够满足你的需要。不过在进入对最速降线问题的理论探讨之前,我们先来讲述一个发生在17世纪的激动人心的数学竞赛的故事。我相信,每一个热爱数学和物理的朋友,都将会为其所振奋,为其所感动。里边渗透的,不仅仅是一次学术的竞争,更是一代又一代的人对真理的追求与探路的不懈精神。

(以下内容来源于网络,科学空间整理)

意大利科学家伽利略在1630年提出一个分析学的基本问题── “一个质点在重力作用下,从一个给定点A到不在它垂直下方的另一点B,如果不计摩擦力,问沿着什么曲线滑下所需时间最短。”这算是这个著名问题的起源了(为什么别人没有想起这个问题呢?所以说大科学家的素质就是思考、创新,要有思想,人没有思想,就和行尸走肉没有什么区别)。可惜的是伽利略说这曲线是圆,但这却是一个错误的答案。

《自然极值》系列——7.悬链线问题

By 苏剑林 | 2010-12-26 | 63724位读者 | 引用约翰与他同时代的110位学者有通信联系,进行学术讨论的信件约有2500封,其中许多已成为珍贵的科学史文献,例如同他的哥哥雅各布以及莱布尼茨、惠更斯等人关于悬链线、最速降线(即旋轮线)和等周问题的通信讨论,虽然相互争论不断,特别是约翰和雅各布互相指责过于尖刻,使兄弟之间时常造成不快,但争论无疑会促进科学的发展,最速降线问题就导致了变分法的诞生。

有意思的是,1690年约翰·伯努利的哥哥雅可比·伯努利曾提出过悬链线问题向数学界征求答案。即:

固定项链的两端,在重力场中让它自然垂下,求项链的曲线方程.

吊桥上方的悬垂钢索,挂着水珠的蜘蛛网,电杆间的电线都是悬链线。伽利略最早注意到悬链线,猜测悬链线是抛物线。1691年莱布尼兹、惠更斯以及约翰·伯努利各自得到正确答案,所用方法是诞生不久的微积分。

从去噪自编码器到生成模型

By 苏剑林 | 2019-10-31 | 93949位读者 | 引用在我看来,几大顶会之中,ICLR的论文通常是最有意思的,因为它们的选题和风格基本上都比较轻松活泼、天马行空,让人有脑洞大开之感。所以,ICLR 2020的投稿论文列表出来之后,我也抽时间粗略过了一下这些论文,确实发现了不少有意思的工作。

其中,我发现了两篇利用去噪自编码器的思想做生成模型的论文,分别是《Learning Generative Models using Denoising Density Estimators》和《Annealed Denoising Score Matching: Learning Energy-Based Models in High-Dimensional Spaces》。由于常规做生成模型的思路我基本都有所了解,所以这种“别具一格”的思路就引起了我的兴趣。细读之下,发现两者的出发点是一致的,但是具体做法又有所不同,最终的落脚点又是一样的,颇有“一题多解”的美妙,遂将这两篇论文放在一起,对比分析一翻。

【中文分词系列】 1. 基于AC自动机的快速分词

By 苏剑林 | 2016-08-17 | 85338位读者 | 引用前言:这个暑假花了不少时间在中文分词和语言模型上面,碰了无数次壁,也得到了零星收获。打算写一个专题,分享一下心得体会。虽说是专题,但仅仅是一些笔记式的集合,并非系统的教程,请读者见谅。

中文分词

关于中文分词的介绍和重要性,我就不多说了,matrix67这里有一篇关于分词和分词算法很清晰的介绍,值得一读。在文本挖掘中,虽然已经有不少文章探索了不分词的处理方法,如本博客的《文本情感分类(三):分词 OR 不分词》,但在一般场合都会将分词作为文本挖掘的第一步,因此,一个有效的分词算法是很重要的。当然,中文分词作为第一步,已经被探索很久了,目前做的很多工作,都是总结性质的,最多是微弱的改进,并不会有很大的变化了。

目前中文分词主要有两种思路:查词典和字标注。首先,查词典的方法有:机械的最大匹配法、最少词数法,以及基于有向无环图的最大概率组合,还有基于语言模型的最大概率组合,等等。查词典的方法简单高效(得益于动态规划的思想),尤其是结合了语言模型的最大概率法,能够很好地解决歧义问题,但对于中文分词一大难度——未登录词(中文分词有两大难度:歧义和未登录词),则无法解决;为此,人们也提出了基于字标注的思路,所谓字标注,就是通过几个标记(比如4标注的是:single,单字成词;begin,多字词的开头;middle,三字以上词语的中间部分;end,多字词的结尾),把句子的正确分词法表示出来。这是一个序列(输入句子)到序列(标记序列)的过程,能够较好地解决未登录词的问题,但速度较慢,而且对于已经有了完备词典的场景下,字标注的分词效果可能也不如查词典方法。总之,各有优缺点(似乎是废话~),实际使用可能会结合两者,像结巴分词,用的是有向无环图的最大概率组合,而对于连续的单字,则使用字标注的HMM模型来识别。

SVD分解(一):自编码器与人工智能

By 苏剑林 | 2017-01-15 | 43068位读者 | 引用咋看上去,SVD分解是比较传统的数据挖掘手段,自编码器是深度学习中一个比较“先进”的概念,应该没啥交集才对。而本文则要说,如果不考虑激活函数,那么两者将是等价的。进一步的思考就可以发现,不管是SVD还是自编码器,我们降维,并不是纯粹地为了减少储存量或者减少计算量,而是“智能”的初步体现。

等价性

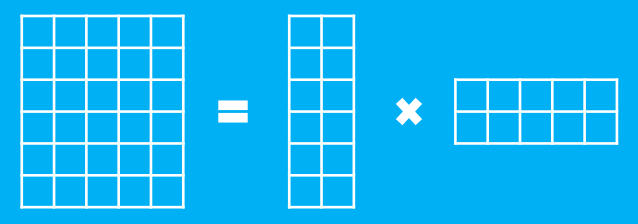

假设有一个$m$行$n$列的庞大矩阵$M_{m\times n}$,这可能使得计算甚至存储上都成问题,于是考虑一个分解,希望找到矩阵$A_{m\times k}$和$B_{k\times n}$,使得

$$M_{m\times n}=A_{m\times k}\times B_{k\times n}$$

这里的乘法是矩阵乘法。如图

![闭区间[a,b]上的连续函数?(x),其最大值为红色点,最小值为蓝色点](/usr/uploads/2010/11/3941873990.png)

最近评论