OCR技术浅探:3. 特征提取(2)

By 苏剑林 | 2016-06-18 | 38821位读者 | 引用OCR技术浅探:7. 语言模型

By 苏剑林 | 2016-06-26 | 50790位读者 | 引用由于图像质量等原因,性能再好的识别模型,都会有识别错误的可能性,为了减少识别错误率,可以将识别问题跟统计语言模型结合起来,通过动态规划的方法给出最优的识别结果.这是改进OCR识别效果的重要方法之一.

转移概率

在我们分析实验结果的过程中,有出现这一案例.由于图像不清晰等可能的原因,导致“电视”一词被识别为“电柳”,仅用图像模型是不能很好地解决这个问题的,因为从图像模型来看,识别为“电柳”是最优的选择.但是语言模型却可以很巧妙地解决这个问题.原因很简单,基于大量的文本数据我们可以统计“电视”一词和“电柳”一词的概率,可以发现“电视”一词的概率远远大于“电柳”,因此我们会认为这个词是“电视”而不是“电柳”.

从概率的角度来看,就是对于第一个字的区域的识别结果$s_1$,我们前面的卷积神经网络给出了“电”、“宙”两个候选字(仅仅选了前两个,后面的概率太小),每个候选字的概率$W(s_1)$分别为0.99996、0.00004;第二个字的区域的识别结果$s_2$,我们前面的卷积神经网络给出了“柳”、“视”、“规”(仅仅选了前三个,后面的概率太小),每个候选字的概率$W(s_2)$分别为0.87838、0.12148、0.00012,因此,它们事实上有六种组合:“电柳”、“电视”、“电规”、“宙柳”、“宙视”、“宙规”.

通用爬虫探索(二):落实到论坛爬取上

By 苏剑林 | 2017-06-06 | 25368位读者 | 引用前述的方案,如果爬取的页面仅仅有单一的有效区域,如博客页、新闻页等,那么基本上来说已经足够了。但是,诸如像论坛这样的具有比较明显的层次划分的网站,我们需要进一步细分。因为经过上述步骤,我们虽然能够把有效文本提取出来,但结果是把所有文本放在一块了。

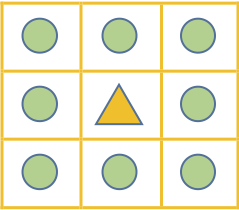

深度优先

而为了给内容进一步“分块”,我们还需要利用DOM树的位置信息。如上一篇的DOM树图,我们需要给每个节点和叶子都编号,即我们需要一个遍历DOM树的方式。这里我们采用“深度优先”的方案。

深度优先搜索算法(英语:Depth-First-Search,简称DFS)是一种用于遍历或搜索树或图的算法。沿着树的深度遍历树的节点,尽可能深的搜索树的分支。当节点v的所在边都己被探寻过,搜索将回溯到发现节点v的那条边的起始节点。这一过程一直进行到已发现从源节点可达的所有节点为止。如果还存在未被发现的节点,则选择其中一个作为源节点并重复以上过程,整个进程反复进行直到所有节点都被访问为止。

bert4keras在手,baseline我有:CLUE基准代码

By 苏剑林 | 2021-10-31 | 75858位读者 | 引用CLUE(Chinese GLUE)是中文自然语言处理的一个评价基准,目前也已经得到了较多团队的认可。CLUE官方Github提供了tensorflow和pytorch的baseline,但并不易读,而且也不方便调试。事实上,不管是tensorflow还是pytorch,不管是CLUE还是GLUE,笔者认为能找到的baseline代码,都很难称得上人性化,试图去理解它们是一件相当痛苦的事情。

所以,笔者决定基于bert4keras实现一套CLUE的baseline。经过一段时间的测试,基本上复现了官方宣称的基准成绩,并且有些任务还更优。最重要的是,所有代码尽量保持了清晰易读的特点,真·“Deep Learning for Humans”。

代码简介

下面简单介绍一下该代码中各个任务baseline的构建思路。在阅读文章和代码之前,请读者自行先观察一下每个任务的数据格式,这里不对任务数据进行详细介绍。

概率分布的熵归一化(Entropy Normalization)

By 苏剑林 | 2021-12-24 | 47779位读者 | 引用在上一篇文章《从熵不变性看Attention的Scale操作》中,我们从熵不变性的角度推导了一个新的Attention Scale,并且实验显示具有熵不变性的新Scale确实能使得Attention的外推性能更好。这时候笔者就有一个很自然的疑问:

有没有类似L2 Normalization之类的操作,可以直接对概率分布进行变换,使得保持原始分布主要特性的同时,让它的熵为指定值?

笔者带着疑问搜索了一番,发现没有类似的研究,于是自己尝试推导了一下,算是得到了一个基本满意的结果,暂称为“熵归一化(Entropy Normalization)”,记录在此,供有需要的读者参考。

幂次变换

首先,假设$n$元分布$(p_1,p_2,\cdots,p_n)$,它的熵定义为

\begin{equation}\mathcal{H} = -\sum_i p_i \log p_i = \mathbb{E}[-\log p_i]\end{equation}

简单做了个Logo~

By 苏剑林 | 2014-06-30 | 26026位读者 | 引用【理科生读小说】来谈谈“四两拨千斤”

By 苏剑林 | 2018-01-28 | 34391位读者 | 引用多彩金庸

在金庸笔下(其实很多武侠小说都如此),武功可以分三种:第一种是实打实的猛,如洪七公的降龙十八掌、金轮法王的龙象般若功等,它们的特点是主要特点是刚猛,比如

乔峰的降龙二十八掌是丐帮前任帮主汪剑通所传,但乔峰生俱异禀,于武功上得天独厚,他这降龙二十八掌摧枯拉朽,无坚不破,较之汪帮主尤有胜过。乔峰见对方双掌齐推,自己如以单掌相抵,倘若拼成平手,自己似乎稍占上风,不免有失恭敬,于是也双掌齐出。他左右双掌中所使掌力,也仍都是外三内七,将大部分掌力留劲不发。

——出自《天龙八部》世纪新修版

第二种是以虚招为主,也就是说你不能比对手猛,你骗倒对手也行,比如桃花岛的落英神剑掌:

这套掌法是黄药师观赏桃花岛中桃花落英缤纷而创制,出招变化多端,还讲究姿势之美。她双臂挥动,四方八面都是掌影,或五虚一实,或八虚一实,直似桃林中狂风忽起、万花齐落,妙在手足飘逸,宛若翩翩起舞,但她一来功力尚浅,二来心存顾惜,未能出掌凌厉如剑。郭靖眼花缭乱,哪里还守得住门户,不提防啪啪啪啪,左肩右肩、前胸后背,接连中了四掌,黄蓉全未使力,郭靖自也不觉疼痛。

——出自《射雕英雄传》世纪新修版

第三种是以巧招为主,它不求一味刚猛,也不一味虚虚实实,而且讲究用力恰到好处,起到“以柔克刚”、“四两拨千斤”之效。显然,这种武功的代表作是太极,另外打狗棒法、乾坤大挪移、还有全真教和古墓派的武功也暗含了这个道理,比如:

增强typecho的搜索功能

By 苏剑林 | 2018-01-09 | 67775位读者 | 引用科学空间是使用typecho程序搭建的博客,侧边栏提供了搜索功能,然而typecho内置搜索功能仅仅是基于字符串的全匹配查找,因此导致很多合理的查询都没法得到结果,比如“2018天象”、“新词算法”都没法给出结果,原因就是文章中都不包含这些字符串。

于是就萌生了加强搜索功能的想法,之前也有读者建议过这个事情。这两天搜索了一下,本来计划用Python下的Whoosh库来建立一个全文检索引擎,但感觉整合和后期维护的工作量太大,还是放弃了。后来想到在typecho自身的搜索上加强,在公司同事(大佬)的帮助下,完成了这个改进。

由于是直接修改typecho源文件实现的改进,因此如果typecho升级后就可能被覆盖,因此在这里做个备忘。

探索

通过在Github检索我发现,typecho的搜索功能是在var/Widget/Archive.php中实现的,具体代码大概在1185~1192行:

最近评论