《Attention is All You Need》浅读(简介+代码)

By 苏剑林 | 2018-01-06 | 743607位读者 | 引用2017年中,有两篇类似同时也是笔者非常欣赏的论文,分别是FaceBook的《Convolutional Sequence to Sequence Learning》和Google的《Attention is All You Need》,它们都算是Seq2Seq上的创新,本质上来说,都是抛弃了RNN结构来做Seq2Seq任务。

这篇博文中,笔者对《Attention is All You Need》做一点简单的分析。当然,这两篇论文本身就比较火,因此网上已经有很多解读了(不过很多解读都是直接翻译论文的,鲜有自己的理解),因此这里尽可能多自己的文字,尽量不重复网上各位大佬已经说过的内容。

序列编码

深度学习做NLP的方法,基本上都是先将句子分词,然后每个词转化为对应的词向量序列。这样一来,每个句子都对应的是一个矩阵$\boldsymbol{X}=(\boldsymbol{x}_1,\boldsymbol{x}_2,\dots,\boldsymbol{x}_t)$,其中$\boldsymbol{x}_i$都代表着第$i$个词的词向量(行向量),维度为$d$维,故$\boldsymbol{X}\in \mathbb{R}^{n\times d}$。这样的话,问题就变成了编码这些序列了。

第一个基本的思路是RNN层,RNN的方案很简单,递归式进行:

\begin{equation}\boldsymbol{y}_t = f(\boldsymbol{y}_{t-1},\boldsymbol{x}_t)\end{equation}

不管是已经被广泛使用的LSTM、GRU还是最近的SRU,都并未脱离这个递归框架。RNN结构本身比较简单,也很适合序列建模,但RNN的明显缺点之一就是无法并行,因此速度较慢,这是递归的天然缺陷。另外我个人觉得RNN无法很好地学习到全局的结构信息,因为它本质是一个马尔科夫决策过程。

《为什么现在的LLM都是Decoder-only的架构?》FAQ

By 苏剑林 | 2023-03-20 | 33434位读者 | 引用上周笔者写了《为什么现在的LLM都是Decoder-only的架构?》,总结了一下我在这个问题上的一些实验结论和猜测。果然是热点问题流量大,paperweekly的转发没多久阅读量就破万了,知乎上点赞数也不少。在几个平台上,陆陆续续收到了读者的一些意见或者疑问,总结了其中一些有代表性的问题,做成了本篇FAQ,希望能进一步帮助大家解决疑惑。

回顾

在《为什么现在的LLM都是Decoder-only的架构?》中,笔者对GPT和UniLM两种架构做了对比实验,然后结合以往的研究经历,猜测了如下结论:

1、输入部分的注意力改为双向不会带来收益,Encoder-Decoder架构的优势很可能只是源于参数翻倍;

2、双向注意力没有带来收益,可能是因为双向注意力的低秩问题导致效果下降。

所以,基于这两点推测,我们得到结论:

在同等参数量、同等推理成本下,Decoder-only架构是最优选择。

哈哈,我的“《圣经》”到了

By 苏剑林 | 2013-06-27 | 47774位读者 | 引用《冲出亚马逊》—在世界立起五星红旗!

By 苏剑林 | 2009-09-04 | 16077位读者 | 引用广州亚运歌曲《重逢》歌词(中英文版)

By 苏剑林 | 2009-09-26 | 21495位读者 | 引用这几天各大报纸和网站都在头版头条刊登了2010年广州亚运会的亚运歌曲《重逢》,最重要的原因当然是因为她的英文版是由杨振宁夫妇翻译的。广州亚运会歌词创作者徐荣凯和杨振宁夫妇是好朋友,他把写好的中文歌词交给两人,希望他们能帮忙找一位专业人士翻译成英文版,杨振宁夫妇竟对这首词爱不释手,很快把译好的英文版歌词传回给了徐荣凯。杨振宁夫妇称只要一说起这首歌就很兴奋。

据说旋律借鉴了广东童谣《落雨大》,感觉这一定会是一首值得收藏的歌!歌曲的中文版将会由歌手毛阿敏孙楠,至于英文版是否也由毛阿敏和孙楠演唱,捞仔则表示,这次录音是计划录一个全中文版和一个B段是英文的版本,如果入围,这首歌将有可能会出现多个版本,包括全中文、全英文、中英文混合等。

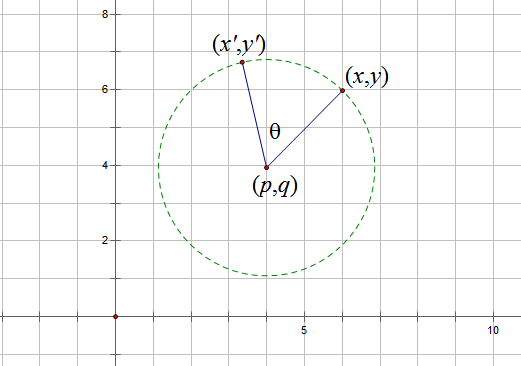

《向量》系列——4.天旋地转(向量,复数,极坐标)

By 苏剑林 | 2010-08-23 | 34847位读者 | 引用《重逢》——最终亚运会会歌

By 苏剑林 | 2010-10-02 | 14546位读者 | 引用《自然极值》系列——1.前言

By 苏剑林 | 2010-11-27 | 45633位读者 | 引用附:期中考过后,课程紧了,自由时间少了,因此科学空间的更新也放缓了。不过BoJone也会尽量地更新一些内容,和大家一同分享学习的乐趣。

上一周和这一周的时间里,BoJone将自己学习物理和极值的一些内容进行了总结和整合,写成了《自然极值》一文。因此从今天起,到十二月的大多数时间里,科学空间将和大家讲述并讨论关于“极值”的问题,希望读者会喜欢这部分内容。当然,我不是专业的研究人员,更不是经验丰富的物理和数学教师,甚至可以说是一个“乳臭未干的小子”,因此,错误在所难免,只希望同好不吝指出,更希冀能够起到我抛出的这一块“砖”能够引出美妙的“玉”。

![闭区间[a,b]上的连续函数?(x),其最大值为红色点,最小值为蓝色点](/usr/uploads/2010/11/3941873990.png)

最近评论