基于量子化假设推导模型的尺度定律(Scaling Law)

By 苏剑林 | 2023-05-18 | 33524位读者 | 引用尺度定律(Scaling Law),指的是模型能力与模型尺度之间的渐近关系。具体来说,模型能力我们可以简单理解为模型的损失函数,模型尺度可以指模型参数量、训练数据量、训练步数等,所谓尺度定律,就是研究损失函数跟参数量、数据量、训练步数等变量的大致关系。《Scaling Laws for Neural Language Models》、《Training Compute-Optimal Large Language Models》等工作的实验结果表明,神经网络的尺度定律多数呈现“幂律(Power law)”的形式。

为什么会是幂律呢?能否从理论上解释呢?论文《The Quantization Model of Neural Scaling》基于“量子化”假设给出了一个颇为有趣的推导。本文一同来欣赏一下。

【生活杂记】炒锅的尽头是铁锅

By 苏剑林 | 2023-11-13 | 54009位读者 | 引用很多会下厨的同学估计都纠结过一件事情,那就是炒锅的选择。

对于炒锅的纠结,归根结底是不粘与方便的权衡。最简单的不粘锅自然是带涂层的不粘锅,如果家里的热源只有电磁炉,并且炒菜习惯比较温和,那么涂层不粘锅往往是最佳选择了。不过,一旦有了明火的燃气灶,又或者是比较喜欢爆炒,那么涂层锅可能就不是那么适合了,毕竟温度过高涂层总有脱落的风险,此时一般就考虑无涂层不粘锅。

无涂层不粘锅也有五花八门的选择,比如朴素的铁锅、带蜂窝纹的不锈钢锅、有钛锅、纯钛锅等等,价格大体上也单调递增。不过用到最后,我觉得大部分人都会回归到朴素的铁锅。

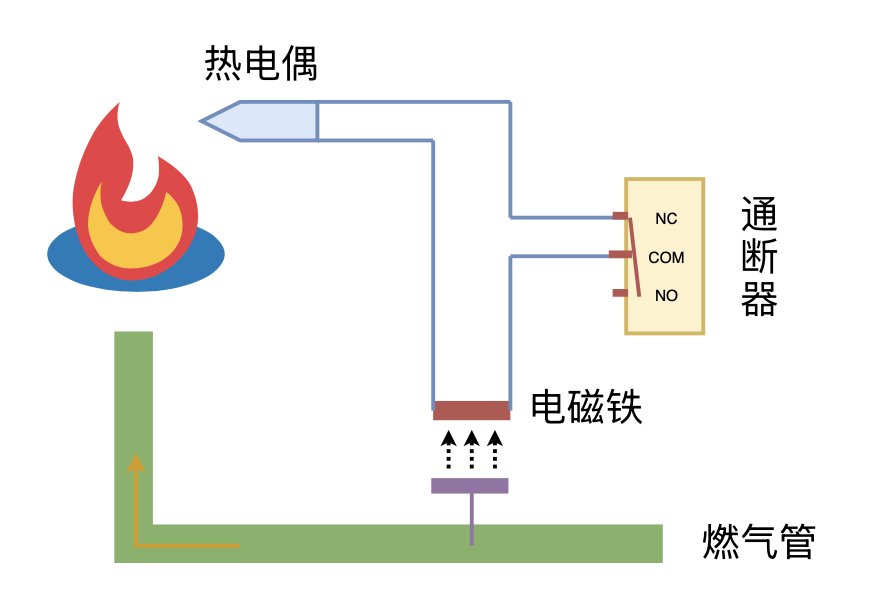

利用“熄火保护 + 通断器”实现燃气灶智能关火

By 苏剑林 | 2024-09-26 | 13062位读者 | 引用折腾windows 8和ubuntu 12

By 苏剑林 | 2012-08-30 | 20698位读者 | 引用这是一篇用Windows 8完成的文章。

快开学了,华师2号就要报道了,所以就提前入手一台手提电脑,联想Z575AM-ASI,四千元的AMD,4核,64位机器。

我的台式机已经是六年前的产品了,联想的家悦系列,只有512MB内存。所以相比之下,这新机器配置还过得去吧,对于CPU,我个人还是倾向于AMD的,因为我的那台家悦台式也是AMD的CPU,所以对它很有好感。新兴的联想专卖店没有AMD手提,所以还得提前向他们预订。

Windows8

手提本身没有预装操作系统,专卖店很随手地为我装了一个win7,而且还只是ghost版本的,时不时会卡死,感觉很不好,刚好前些日子在网上开始发布Windows8了,所以就马上把Win7格掉,装上Windows8了。安装过程很顺利,由于还没有正式发布,所以还没有激活,这段时间纯粹体验中。等正式版发布了,再计划买一个正版光盘吧

太阳中心的压强和温度

By 苏剑林 | 2010-07-19 | 31447位读者 | 引用为了准备IOAA,同时也加深对天体物理的理解,所以就系统地学习一下天体物理学了。今天看到“太阳”这一章,并由此简单估算了一下太阳的中心压强和温度。

天体物理学给出了关于恒星结构的一些方程。假设存在一颗各项同性的球形恒星,则有

$\frac{dm(r)}{dr}=4\pi r^2 \rho(r)$————质量方程

其中m(r)是与恒星球心距离为r的一个球形区域内的总质量,$\rho(r)$是距离球心r处的物质的密度。我们也可以写成积分的形式

$$m(r)=\int_0^R 4\pi r^2 \rho(r)dr$$

其中R是恒星半径。这个方程的意思其实就是每一个壳层的质量叠加,所以就不详细推导了。

[备忘]历史天气查询

By 苏剑林 | 2013-04-27 | 52716位读者 | 引用天气预报查询我相信大家用过不少了,如果精度要求不高,那么随便打开谷歌输入“城市名+tq”就可以查询到了。可是你有没有想过过去的天气怎么查询呢?比如我要研究最近十年的气候变化,我想得到最近十年每天的天气数据(最高温、最低温等等),那要怎么查呢?

我在很早以前就想查询到这些数据,但是在网上随便搜索了一下,无果,所以一直搁置着。前两天一个同学问我同样的问题,所以就查找了一番,功夫不负有心人,终于找到了。原来关键字应该是“历史天气查询”(之前我搜索了很多关键字,比如“气象数据下载”、“气象统计”等等,都没有搜索到有用的结果)。

一个支持历史天气查询的中文网站是:

http://lishi.tianqi.com/

AdaX优化器浅析(附开源实现)

By 苏剑林 | 2020-05-11 | 33181位读者 | 引用这篇文章简单介绍一个叫做AdaX的优化器,来自《AdaX: Adaptive Gradient Descent with Exponential Long Term Memory》。介绍这个优化器的原因是它再次印证了之前在《AdaFactor优化器浅析(附开源实现)》一文中提到的一个结论,两篇文章可以对比着阅读。

Adam & AdaX

AdaX的更新格式是

\begin{equation}\left\{\begin{aligned}&g_t = \nabla_{\theta} L(\theta_t)\\

&m_t = \beta_1 m_{t-1} + \left(1 - \beta_1\right) g_t\\

&v_t = (1 + \beta_2) v_{t-1} + \beta_2 g_t^2\\

&\hat{v}_t = v_t\left/\left(\left(1 + \beta_2\right)^t - 1\right)\right.\\

&\theta_t = \theta_{t-1} - \alpha_t m_t\left/\sqrt{\hat{v}_t + \epsilon}\right.

\end{aligned}\right.\end{equation}

其中$\beta_2$的默认值是$0.0001$。对了,顺便附上自己的Keras实现:https://github.com/bojone/adax

在生活上,我是一个比较传统的人,因此每到节日我都会尽量回家跟家人团聚。也许会让大家比较吃惊的是,今年的国庆是我第一个不在家的国庆。的确,从小学到高中,上学的地方离家都比较近,每周回去一次都是不成问题的。现在来到了广州,就不能太随心了。虽然跟很多同学相比,我离家还是比较近的,但是来回也要考虑车费、时间等等。国庆假期时间虽然很长,但是中秋已经回去一趟了,所以我决定国庆就不再回去了。

对我来说,中秋跟国庆相比,中秋的意义更大些。所以我选择了国庆不回家。对家人而言,看到自己平安就好,因此哪一天回去他们都会很高兴,当然,对于农村人来说,中秋的味道更浓,更希望团聚。

最近评论