欲对接广义相对论,新量子引力模型能否成功?

By 苏剑林 | 2009-09-05 | 16317位读者 | 引用时至目前为止,理论物理上最深奥的问题之一,就是调和广义相对论与量子力学,而一个令物理学家们无比兴奋的,同时也争论不休的量子引力新模型,是否能重新书写物理学理论?针对不久前诞生于美国劳伦斯伯克利实验室的“霍扎瓦模型”,美国得克萨斯A&M大学科学家对其进一步研究后得出中肯的结论,并将结果与值得商榷的内容发表于8月24日出版的《物理评论快报》杂志。

量子引力的新曙光

量子引力主要就是尝试将量子力学与广义相对论合并在一起,描述对重力场进行量子化,属于万有理论之一隅。但应该如何结合,又如何让二者在微观长度等级下维持正确性,以及任何候选的量子引力论又能提供什么样可证实的预测,这是当前的物理学悬而未决的问题。遗憾的是,量子引力所探讨的能量与尺度,乃是此前实验室条件下无法观测得到的,尽管可能,且可以透过天文观测来检验,但仍属少数特例,关于量子引力理论发展上的提示一直未能成功。

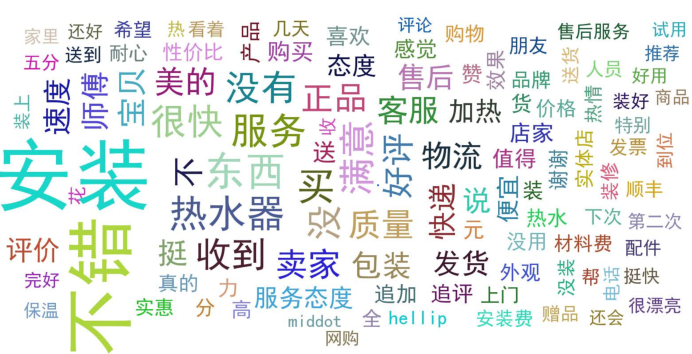

文本情感分类(一):传统模型

By 苏剑林 | 2015-06-22 | 215171位读者 | 引用前言:四五月份的时候,我参加了两个数据挖掘相关的竞赛,分别是物电学院举办的“亮剑杯”,以及第三届 “泰迪杯”全国大学生数据挖掘竞赛。很碰巧的是,两个比赛中,都有一题主要涉及到中文情感分类工作。在做“亮剑杯”的时候,由于我还是初涉,水平有限,仅仅是基于传统的思路实现了一个简单的文本情感分类模型。而在后续的“泰迪杯”中,由于学习的深入,我已经基本了解深度学习的思想,并且用深度学习的算法实现了文本情感分类模型。因此,我打算将两个不同的模型都放到博客中,供读者参考。刚入门的读者,可以从中比较两者的不同,并且了解相关思路。高手请一笑置之。

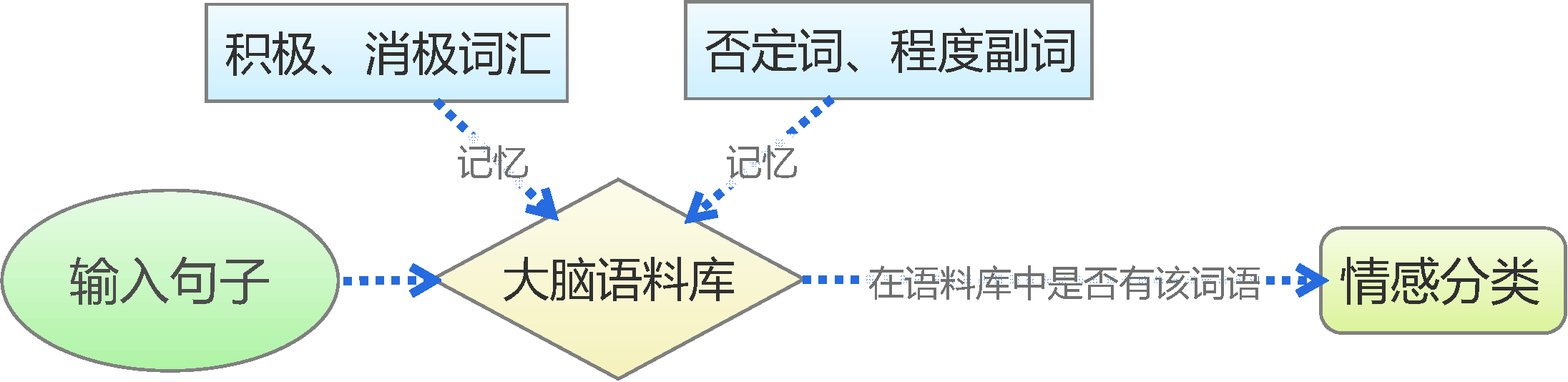

基于情感词典

漫话模型|模型与选芒果

By 苏剑林 | 2015-07-15 | 36161位读者 | 引用很多人觉得“模型”、“大数据”、“机器学习”这些字眼很高大很神秘,事实上,它跟我们生活中选水果差不了多少。本文用了几千字,来试图教会大家怎么选芒果...

模型的比喻

假如我要从一批芒果中,找出好吃的那个来。而我不能直接切开芒果尝尝,所以我只能观察芒果,能观察到的量有颜色、表面的气味、大小等等,这些就是我们能够收集到的信息(特征)。

生活中还要很多这样的例子,比如买火柴(可能年轻的城里人还没见过火柴?),如何判断一盒火柴的质量?难道要每根火柴都划划,看看着不着火?显然不行,我们最多也只能划几根,全部划了,火柴也不成火柴了。当然,我们还能看看火柴的样子,闻闻火柴的气味,这些动作是可以接受的。

文本情感分类(二):深度学习模型

By 苏剑林 | 2015-08-04 | 586470位读者 | 引用“熵”不起:从熵、最大熵原理到最大熵模型(一)

By 苏剑林 | 2015-12-01 | 77050位读者 | 引用熵的概念

作为一名物理爱好者,我一直对统计力学中“熵”这个概念感到神秘和好奇。因此,当我接触数据科学的时候,我也对最大熵模型产生了浓厚的兴趣。

熵是什么?在通俗的介绍中,熵一般有两种解释:(1)熵是不确定性的度量;(2)熵是信息的度量。看上去说的不是一回事,其实它们说的就是同一个意思。首先,熵是不确定性的度量,它衡量着我们对某个事物的“无知程度”。熵为什么又是信息的度量呢?既然熵代表了我们对事物的无知,那么当我们从“无知”到“完全认识”这个过程中,就会获得一定的信息量,我们开始越无知,那么到达“完全认识”时,获得的信息量就越大,因此,作为不确定性的度量的熵,也可以看作是信息的度量,说准确点,是我们能从中获得的最大的信息量。

“熵”不起:从熵、最大熵原理到最大熵模型(二)

By 苏剑林 | 2015-12-11 | 79716位读者 | 引用上集回顾

在第一篇中,笔者介绍了“熵”这个概念,以及它的一些来龙去脉。熵的公式为

$$S=-\sum_x p(x)\log p(x)\tag{1}$$

或

$$S=-\int p(x)\log p(x) dx\tag{2}$$

并且在第一篇中,我们知道熵既代表了不确定性,又代表了信息量,事实上它们是同一个概念。

说完了熵这个概念,接下来要说的是“最大熵原理”。最大熵原理告诉我们,当我们想要得到一个随机事件的概率分布时,如果没有足够的信息能够完全确定这个概率分布(可能是不能确定什么分布,也可能是知道分布的类型,但是还有若干个参数没确定),那么最为“保险”的方案是选择使得熵最大的分布。

最大熵原理

承认我们的无知

很多文章在介绍最大熵原理的时候,会引用一句著名的句子——“不要把鸡蛋放在同一个篮子里”——来通俗地解释这个原理。然而,笔者窃以为这句话并没有抓住要点,并不能很好地体现最大熵原理的要义。笔者认为,对最大熵原理更恰当的解释是:承认我们的无知!

“熵”不起:从熵、最大熵原理到最大熵模型(三)

By 苏剑林 | 2015-12-20 | 64467位读者 | 引用上集回顾

在上一篇文章中,笔者分享了自己对最大熵原理的认识,包括最大熵原理的意义、最大熵原理的求解以及一些简单而常见的最大熵原理的应用。在上一篇的文末,我们还通过最大熵原理得到了正态分布,以此来说明最大熵原理的深刻内涵和广泛意义。

本文中,笔者将介绍基于最大熵原理的模型——最大熵模型。本文以有监督的分类问题来介绍最大熵模型,所谓有监督,就是基于已经标签好的数据进行的。

事实上,第二篇文章的最大熵原理才是主要的,最大熵模型,实质上只是最大熵原理的一个延伸,或者说应用。

最大熵模型

分类:意味着什么?

在引入最大熵模型之前,我们先来多扯一点东西,谈谈分类问题意味着什么。假设我们有一批标签好的数据:

$$\begin{array}{c|cccccccc}

\hline

\text{数据}x & 1 & 2 & 3 & 4 & 5 & 6 & \dots & 100 \\

\hline

\text{标签}y & 1 & 0 & 1 & 0 & 1 & 0 & \dots & 0\\

\hline \end{array}$$

路径积分系列:2.随机游走模型

By 苏剑林 | 2016-05-30 | 51724位读者 | 引用随机游走模型形式简单,但通过它可以导出丰富的结果,它是物理中各种扩散模型的基础之一,它也等价于随机过程中的布朗运动.

笔者所阅的文献表明,数学家已经对对称随机游走问题作了充分研究[2],也探讨了随机游走问题与偏微分方程的关系[3],并且还研究过不对称随机游走问题[4]. 然而,已有结果的不足之处有:1、在推导随机游走问题的概率分布或者偏微分方程之时,所用的方法不够简洁明了;2、没有研究更一般的不对称随机游走问题.

本章弥补了这一不足,首先通过母函数和傅里叶变换的方法,推导出了不对称随机游走问题所满足的偏微分方程,并且提出,由于随机游走容易通过计算机模拟,因此通过随机游走来模拟偏微分方程的解是一种有效的数值途径.

模型简介

本节通过一个本质上属于二项分布的走格子问题来引入随机游走.

考虑实数轴上的一个粒子,在$t=0$时刻它位于原点,每秒钟它以相等的概率向前或向后移动一格($+1$或$-1$),问$n$秒后它所处位置的概率分布.

最近评论