生成扩散模型漫谈(四):DDIM = 高观点DDPM

By 苏剑林 | 2022-07-27 | 395926位读者 |相信很多读者都听说过甚至读过克莱因的《高观点下的初等数学》这套书,顾名思义,这是在学到了更深入、更完备的数学知识后,从更高的视角重新审视过往学过的初等数学,以得到更全面的认知,甚至达到温故而知新的效果。类似的书籍还有很多,比如《重温微积分》、《复分析:可视化方法》等。

回到扩散模型,目前我们已经通过三篇文章从不同视角去解读了DDPM,那么它是否也存在一个更高的理解视角,让我们能从中得到新的收获呢?当然有,《Denoising Diffusion Implicit Models》介绍的DDIM模型就是经典的案例,本文一起来欣赏它。

思路分析 #

在《生成扩散模型漫谈(三):DDPM = 贝叶斯 + 去噪》中,我们提到过该文章所介绍的推导跟DDIM紧密相关。具体来说,文章的推导路线可以简单归纳如下:

\begin{equation}p(\boldsymbol{x}_t|\boldsymbol{x}_{t-1})\xrightarrow{\text{推导}}p(\boldsymbol{x}_t|\boldsymbol{x}_0)\xrightarrow{\text{推导}}p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t, \boldsymbol{x}_0)\xrightarrow{\text{近似}}p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t)\end{equation}

这个过程是一步步递进的。然而,我们发现最终结果有着两个特点:

1、损失函数只依赖于$p(\boldsymbol{x}_t|\boldsymbol{x}_0)$;

2、采样过程只依赖于$p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t)$。

也就是说,尽管整个过程是以$p(\boldsymbol{x}_t|\boldsymbol{x}_{t-1})$为出发点一步步往前推的,但是从结果上来看,压根儿就没$p(\boldsymbol{x}_t|\boldsymbol{x}_{t-1})$的事。那么,我们大胆地“异想天开”一下:

高观点1: 既然结果跟$p(\boldsymbol{x}_t|\boldsymbol{x}_{t-1})$无关,可不可以干脆“过河拆桥”,将$p(\boldsymbol{x}_t|\boldsymbol{x}_{t-1})$从整个推导过程中去掉?

DDIM正是这个“异想天开”的产物!

待定系数 #

可能有读者会想,根据上一篇文章所用的贝叶斯定理

\begin{equation}p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t, \boldsymbol{x}_0) = \frac{p(\boldsymbol{x}_t|\boldsymbol{x}_{t-1})p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_0)}{p(\boldsymbol{x}_t|\boldsymbol{x}_0)}\end{equation}

没有给定$p(\boldsymbol{x}_t|\boldsymbol{x}_{t-1})$怎么能得到$p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t, \boldsymbol{x}_0)$?这其实是思维过于定式了,理论上在没有给定$p(\boldsymbol{x}_t|\boldsymbol{x}_{t-1})$的情况下,$p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t, \boldsymbol{x}_0)$的解空间更大,某种意义上来说是更加容易推导,此时它只需要满足边际分布条件:

\begin{equation}\int p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t, \boldsymbol{x}_0) p(\boldsymbol{x}_t|\boldsymbol{x}_0) d\boldsymbol{x}_t = p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_0)\label{eq:margin}\end{equation}

我们用待定系数法来求解这个方程。在上一篇文章中,所解出的$p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t, \boldsymbol{x}_0)$是一个正态分布,所以这一次我们可以更一般地设

\begin{equation}p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t, \boldsymbol{x}_0) = \mathcal{N}(\boldsymbol{x}_{t-1}; \kappa_t \boldsymbol{x}_t + \lambda_t \boldsymbol{x}_0, \sigma_t^2 \boldsymbol{I})\end{equation}

其中$\kappa_t,\lambda_t,\sigma_t$都是待定系数,而为了不重新训练模型,我们不改变$p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_0)$和$p(\boldsymbol{x}_t|\boldsymbol{x}_0)$,于是我们可以列出

\begin{array}{c|c|c}

\hline

\text{记号} & \text{含义} & \text{采样}\\

\hline

p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_0) & \mathcal{N}(\boldsymbol{x}_{t-1};\bar{\alpha}_{t-1} \boldsymbol{x}_0,\bar{\beta}_{t-1}^2 \boldsymbol{I}) & \boldsymbol{x}_{t-1} = \bar{\alpha}_{t-1} \boldsymbol{x}_0 + \bar{\beta}_{t-1} \boldsymbol{\varepsilon} \\

\hline

p(\boldsymbol{x}_t|\boldsymbol{x}_0) & \mathcal{N}(\boldsymbol{x}_t;\bar{\alpha}_t \boldsymbol{x}_0,\bar{\beta}_t^2 \boldsymbol{I}) & \boldsymbol{x}_t = \bar{\alpha}_t \boldsymbol{x}_0 + \bar{\beta}_t \boldsymbol{\varepsilon}_1 \\

\hline

p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t, \boldsymbol{x}_0) & \mathcal{N}(\boldsymbol{x}_{t-1}; \kappa_t \boldsymbol{x}_t + \lambda_t \boldsymbol{x}_0, \sigma_t^2 \boldsymbol{I}) & \boldsymbol{x}_{t-1} = \kappa_t \boldsymbol{x}_t + \lambda_t \boldsymbol{x}_0 + \sigma_t \boldsymbol{\varepsilon}_2 \\

\hline

{\begin{array}{c}\int p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t, \boldsymbol{x}_0) \\

p(\boldsymbol{x}_t|\boldsymbol{x}_0) d\boldsymbol{x}_t\end{array}} & & {\begin{aligned}\boldsymbol{x}_{t-1} =&\, \kappa_t \boldsymbol{x}_t + \lambda_t \boldsymbol{x}_0 + \sigma_t \boldsymbol{\varepsilon}_2 \\

=&\, \kappa_t (\bar{\alpha}_t \boldsymbol{x}_0 + \bar{\beta}_t \boldsymbol{\varepsilon}_1) + \lambda_t \boldsymbol{x}_0 + \sigma_t \boldsymbol{\varepsilon}_2 \\

=&\, (\kappa_t \bar{\alpha}_t + \lambda_t) \boldsymbol{x}_0 + (\kappa_t\bar{\beta}_t \boldsymbol{\varepsilon}_1 + \sigma_t \boldsymbol{\varepsilon}_2) \\

\end{aligned}} \\

\hline

\end{array}

其中$\boldsymbol{\varepsilon},\boldsymbol{\varepsilon}_1,\boldsymbol{\varepsilon}_2\sim \mathcal{N}(\boldsymbol{0},\boldsymbol{I})$,并且由正态分布的叠加性我们知道$\kappa_t\bar{\beta}_t \boldsymbol{\varepsilon}_1 + \sigma_t \boldsymbol{\varepsilon}_2\sim \sqrt{\kappa_t^2\bar{\beta}_t^2 + \sigma_t^2} \boldsymbol{\varepsilon}$。对比$\boldsymbol{x}_{t-1}$的两个采样形式,我们发现要想$\eqref{eq:margin}$成立,只需要满足两个方程

\begin{equation}\bar{\alpha}_{t-1} = \kappa_t \bar{\alpha}_t + \lambda_t, \qquad\bar{\beta}_{t-1} = \sqrt{\kappa_t^2\bar{\beta}_t^2 + \sigma_t^2}\end{equation}

可以看到有三个未知数,但只有两个方程,这就是为什么说没有给定$p(\boldsymbol{x}_t|\boldsymbol{x}_{t-1})$时解空间反而更大了。将$\sigma_t$视为可变参数,可以解出

\begin{equation}\kappa_t = \frac{\sqrt{\bar{\beta}_{t-1}^2 - \sigma_t^2}}{\bar{\beta}_t},\qquad \lambda_t = \bar{\alpha}_{t-1} - \frac{\bar{\alpha}_t\sqrt{\bar{\beta}_{t-1}^2 - \sigma_t^2}}{\bar{\beta}_t}\end{equation}

或者写成

\begin{equation}p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t, \boldsymbol{x}_0) = \mathcal{N}\left(\boldsymbol{x}_{t-1}; \frac{\sqrt{\bar{\beta}_{t-1}^2 - \sigma_t^2}}{\bar{\beta}_t} \boldsymbol{x}_t + \left(\bar{\alpha}_{t-1} - \frac{\bar{\alpha}_t\sqrt{\bar{\beta}_{t-1}^2 - \sigma_t^2}}{\bar{\beta}_t}\right) \boldsymbol{x}_0, \sigma_t^2 \boldsymbol{I}\right)\label{eq:p-xt-x0}\end{equation}

方便起见,我们约定$\bar{\alpha}_0=1, \bar{\beta}_0=0$。特别地,这个结果并不需要限定$\bar{\alpha}_t^2 + \bar{\beta}_t^2 = 1$,不过为了简化参数设置,同时也为了跟以往的结果对齐,这里还是约定$\bar{\alpha}_t^2 + \bar{\beta}_t^2 = 1$。

一如既往 #

现在我们在只给定$p(\boldsymbol{x}_t|\boldsymbol{x}_0)$、$p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_0)$的情况下,通过待定系数法求解了$p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t, \boldsymbol{x}_0)$的一簇解,它带有一个自由参数$\sigma_t$。用《生成扩散模型漫谈(一):DDPM = 拆楼 + 建楼》中的“拆楼-建楼”类比来说,就是我们知道楼会被拆成什么样【$p(\boldsymbol{x}_t|\boldsymbol{x}_0)$、$p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_0)$】,但是不知道每一步怎么拆【$p(\boldsymbol{x}_t|\boldsymbol{x}_{t-1})$】,然后希望能够从中学会每一步怎么建【$p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t)$】。当然,如果我们想看看每一步怎么拆的话,也可以反过来用贝叶斯公式

\begin{equation} p(\boldsymbol{x}_t|\boldsymbol{x}_{t-1}, \boldsymbol{x}_0) = \frac{p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t, \boldsymbol{x}_0) p(\boldsymbol{x}_t|\boldsymbol{x}_0)}{p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_0)}\end{equation}

接下来的事情,就跟上一篇文章一模一样了:我们最终想要$p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t)$而不是$p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t, \boldsymbol{x}_0)$,所以我们希望用

\begin{equation}\bar{\boldsymbol{\mu}}(\boldsymbol{x}_t) = \frac{1}{\bar{\alpha}_t}\left(\boldsymbol{x}_t - \bar{\beta}_t \boldsymbol{\epsilon}_{\boldsymbol{\theta}}(\boldsymbol{x}_t, t)\right)\end{equation}

来估计$\boldsymbol{x}_0$,由于没有改动$p(\boldsymbol{x}_t|\boldsymbol{x}_0)$,所以训练所用的目标函数依然是$\left\Vert\boldsymbol{\varepsilon} - \boldsymbol{\epsilon}_{\boldsymbol{\theta}}(\bar{\alpha}_t \boldsymbol{x}_0 + \bar{\beta}_t \boldsymbol{\varepsilon}, t)\right\Vert^2$(除去权重系数),也就是说训练过程没有改变,我们可以用回DDPM训练好的模型。而用$\bar{\boldsymbol{\mu}}(\boldsymbol{x}_t)$替换掉式$\eqref{eq:p-xt-x0}$中的$\boldsymbol{x}_0$后,得到

\begin{equation}\begin{aligned}

p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t) \approx&\, p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t, \boldsymbol{x}_0=\bar{\boldsymbol{\mu}}(\boldsymbol{x}_t)) \\

=&\, \mathcal{N}\left(\boldsymbol{x}_{t-1}; \frac{1}{\alpha_t}\left(\boldsymbol{x}_t - \left(\bar{\beta}_t - \alpha_t\sqrt{\bar{\beta}_{t-1}^2 - \sigma_t^2}\right) \boldsymbol{\epsilon}_{\boldsymbol{\theta}}(\boldsymbol{x}_t, t)\right), \sigma_t^2 \boldsymbol{I}\right)

\end{aligned}\label{eq:p-xt-x0-2}\end{equation}

这就求出了生成过程所需要的$p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t)$,其中$\alpha_t=\frac{\bar{\alpha}_t}{\bar{\alpha}_{t-1}}$。它的特点是训练过程没有变化(也就是说最终保存下来的模型没有变化),但生成过程却有一个可变动的参数$\sigma_t$,就是这个参数给DDPM带来了新鲜的结果。

几个例子 #

原则上来说,我们对$\sigma_t$没有过多的约束,但是不同$\sigma_t$的采样过程会呈现出不同的特点,我们举几个例子进行分析。

第一个简单例子就是取$\sigma_t = \frac{\bar{\beta}_{t-1}\beta_t}{\bar{\beta}_t}$,其中$\beta_t = \sqrt{1 - \alpha_t^2}$,相应地有

\begin{equation}\small{p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t) \approx p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t, \boldsymbol{x}_0=\bar{\boldsymbol{\mu}}(\boldsymbol{x}_t)) = \mathcal{N}\left(\boldsymbol{x}_{t-1}; \frac{1}{\alpha_t}\left(\boldsymbol{x}_t - \frac{\beta_t^2}{\bar{\beta}_t}\boldsymbol{\epsilon}_{\boldsymbol{\theta}}(\boldsymbol{x}_t, t)\right),\frac{\bar{\beta}_{t-1}^2\beta_t^2}{\bar{\beta}_t^2} \boldsymbol{I}\right)}\label{eq:choice-1}\end{equation}

这就是上一篇文章所推导的DDPM。特别是,DDIM论文中还对$\sigma_t = \eta\frac{\bar{\beta}_{t-1}\beta_t}{\bar{\beta}_t}$做了对比实验,其中$\eta\in[0, 1]$。

第二个例子就是取$\sigma_t = \beta_t$,这也是前两篇文章所指出的$\sigma_t$的两个选择之一,在此选择下式$\eqref{eq:p-xt-x0-2}$未能做进一步的化简,但DDIM的实验结果显示此选择在DDPM的标准参数设置下表现还是很好的。

最特殊的一个例子是取$\sigma_t = 0$,此时从$\boldsymbol{x}_t$到$\boldsymbol{x}_{t-1}$是一个确定性变换

\begin{equation}\boldsymbol{x}_{t-1} = \frac{1}{\alpha_t}\left(\boldsymbol{x}_t - \left(\bar{\beta}_t - \alpha_t \bar{\beta}_{t-1}\right) \boldsymbol{\epsilon}_{\boldsymbol{\theta}}(\boldsymbol{x}_t, t)\right)\label{eq:sigma=0}\end{equation}

这也是DDIM论文中特别关心的一个例子,准确来说,原论文的DDIM就是特指$\sigma_t=0$的情形,其中“I”的含义就是“Implicit”,意思这是一个隐式的概率模型,因为跟其他选择所不同的是,此时从给定的$\boldsymbol{x}_T = \boldsymbol{z}$出发,得到的生成结果$\boldsymbol{x}_0$是不带随机性的。后面我们将会看到,这在理论上和实用上都带来了一些好处。

加速生成 #

值得指出的是,在这篇文章中我们没有以$p(\boldsymbol{x}_t|\boldsymbol{x}_{t-1})$为出发点,所以前面的所有结果实际上全都是以$\bar{\alpha}_t,\bar{\beta}_t$相关记号给出的,而$\alpha_t,\beta_t$则是通过$\alpha_t=\frac{\bar{\alpha}_t}{\bar{\alpha}_{t-1}}$和$\beta_t = \sqrt{1 - \alpha_t^2}$派生出来的记号。从损失函数$\left\Vert\boldsymbol{\varepsilon} - \boldsymbol{\epsilon}_{\boldsymbol{\theta}}(\bar{\alpha}_t \boldsymbol{x}_0 + \bar{\beta}_t \boldsymbol{\varepsilon}, t)\right\Vert^2$可以看出,给定了各个$\bar{\alpha}_t$,训练过程也就确定了。

从这个过程中,DDIM进一步留意到了如下事实:

高观点2: DDPM的训练结果实质上包含了它的任意子序列参数的训练结果。

具体来说,设$\boldsymbol{\tau} = [\tau_1,\tau_2,\dots,\tau_{\dim(\boldsymbol{\tau})}]$是$[1,2,\cdots,T]$的任意子序列,那么我们以$\bar{\alpha}_{\tau_1},\bar{\alpha}_{\tau_2},\cdots,\bar{\alpha}_{\dim(\boldsymbol{\tau})}$为参数训练一个扩散步数为$\dim(\boldsymbol{\tau})$步的DDPM,其目标函数实际上是原来以$\bar{\alpha}_1,\bar{\alpha}_2,\cdots,\bar{\alpha}_T$的$T$步DDPM的目标函数的一个子集!所以在模型拟合能力足够好的情况下,它其实包含了任意子序列参数的训练结果。

那么反过来想,如果有一个训练好的$T$步DDPM模型,我们也可以将它当成是以$\bar{\alpha}_{\tau_1},\bar{\alpha}_{\tau_2},\cdots,\bar{\alpha}_{\dim(\boldsymbol{\tau})}$为参数训练出来的$\dim(\boldsymbol{\tau})$步模型,而既然是$\dim(\boldsymbol{\tau})$步的模型,生成过程也就只需要$\dim(\boldsymbol{\tau})$步了,根据式$\eqref{eq:p-xt-x0-2}$有:

\begin{equation}p(\boldsymbol{x}_{\tau_{i-1}}|\boldsymbol{x}_{\tau_i}) \approx \mathcal{N}\left(\boldsymbol{x}_{\tau_{i-1}}; \frac{\bar{\alpha}_{\tau_{i-1}}}{\bar{\alpha}_{\tau_i}}\left(\boldsymbol{x}_{\tau_i} - \left(\bar{\beta}_{\tau_i} - \frac{\bar{\alpha}_{\tau_i}}{\bar{\alpha}_{\tau_{i-1}}}\sqrt{\bar{\beta}_{\tau_{i-1}}^2 - \tilde{\sigma}_{\tau_i}^2}\right) \boldsymbol{\epsilon}_{\boldsymbol{\theta}}(\boldsymbol{x}_{\tau_i}, \tau_i)\right), \tilde{\sigma}_{\tau_i}^2 \boldsymbol{I}\right)\end{equation}

这就是加速采样的生成过程了,从原来的$T$步扩散生成变成了$\dim(\boldsymbol{\tau})$步。要注意不能直接将式$\eqref{eq:p-xt-x0-2}$的$\alpha_t$换成$\alpha_{\tau_i}$,因为我们说过$\alpha_t$是派生记号而已,它实际上等于$\frac{\bar{\alpha}_t}{\bar{\alpha}_{t-1}}$,因此$\alpha_t$要换成$\frac{\bar{\alpha}_{\tau_i}}{\bar{\alpha}_{\tau_{i-1}}}$才对。同理,$\tilde{\sigma}_{\tau_i}$也不是直接取$\sigma_{\tau_i}$,而是在将其定义全部转化为$\bar{\alpha},\bar{\beta}$符号后,将$t$替换为$\tau_i$、$t-1$替换为$\tau_{i-1}$,比如式$\eqref{eq:choice-1}$对应的$\tilde{\sigma}_{\tau_i}$为

\begin{equation}\sigma_t = \frac{\bar{\beta}_{t-1}\beta_t}{\bar{\beta}_t}=\frac{\bar{\beta}_{t-1}}{\bar{\beta}_t}\sqrt{1 - \frac{\bar{\alpha}_t^2}{\bar{\alpha}_{t-1}^2}}\quad\to\quad\frac{\bar{\beta}_{\tau_{i-1}}}{\bar{\beta}_{\tau_i}}\sqrt{1 - \frac{\bar{\alpha}_{\tau_i}^2}{\bar{\alpha}_{\tau_{i-1}}^2}}=\tilde{\sigma}_{\tau_i}\end{equation}

可能读者又想问,我们为什么干脆不直接训练一个$\dim(\boldsymbol{\tau})$步的扩散模型,而是要先训练$T > \dim(\boldsymbol{\tau})$步然后去做子序列采样?笔者认为可能有两方面的考虑:一方面从$\dim(\boldsymbol{\tau})$步生成来说,训练更多步数的模型也许能增强泛化能力;另一方面,通过子序列$\boldsymbol{\tau}$进行加速只是其中一种加速手段,训练更充分的$T$步允许我们尝试更多的其他加速手段,但并不会显著增加训练成本。

实验结果 #

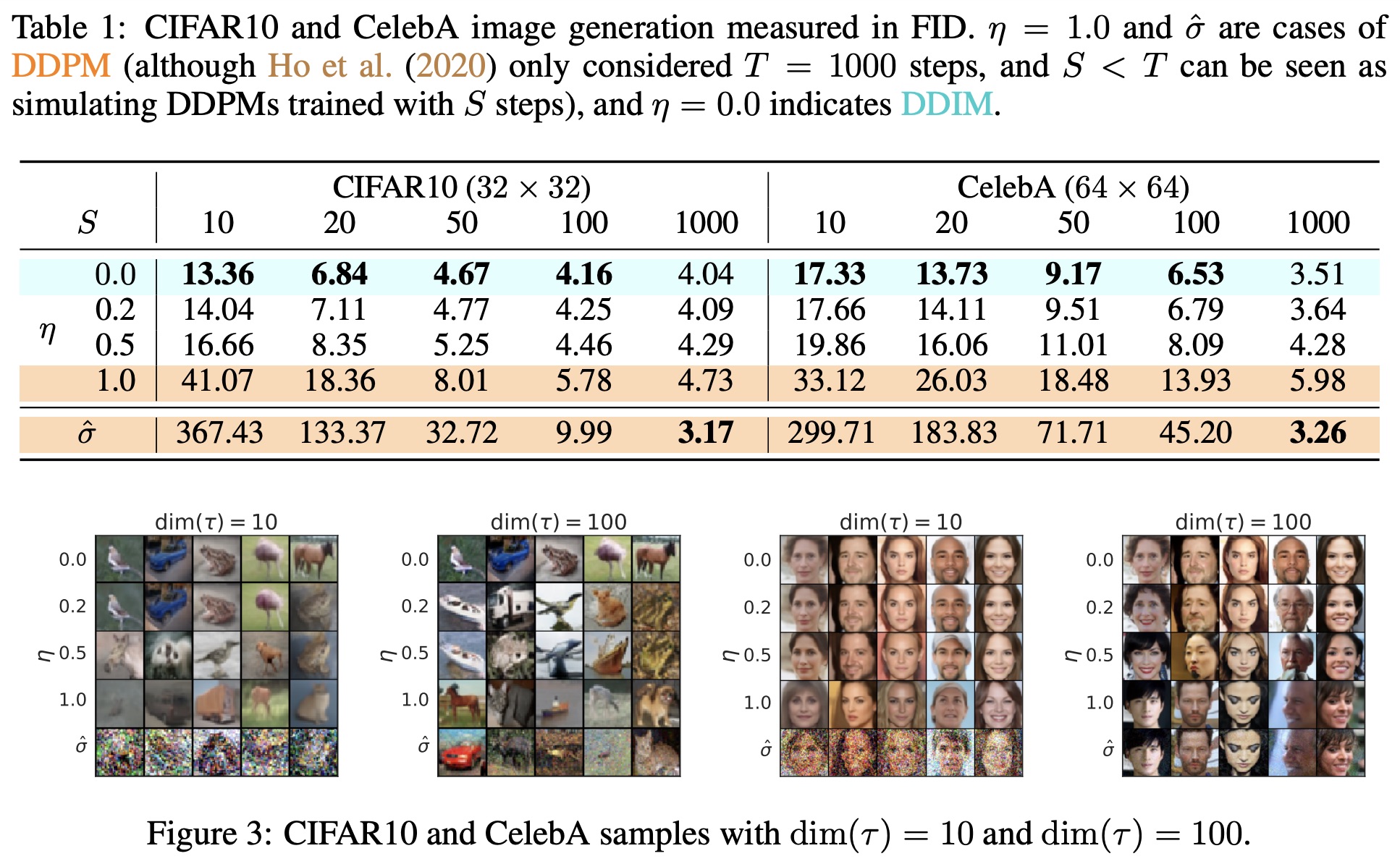

原论文对不同的噪声强度和扩散步数$\dim(\boldsymbol{\tau})$做了组合对比,大致上的结果是“噪声越小,加速后的生成效果越好”,如下图

笔者的参考实现如下:

个人的实验结论是:

1、可能跟直觉相反,生成过程中的$\sigma_t$越小,最终生成图像的噪声和多样性反而相对来说越大;

2、扩散步数$\dim(\boldsymbol{\tau})$越少,生成的图片更加平滑,多样性也会有所降低;

3、结合1、2两点得知,在扩散步数$\dim(\boldsymbol{\tau})$减少时,可以适当缩小$\sigma_t$,以保持生成图片质量大致不变,这跟DDIM原论文的实验结论是一致的;

4、在$\sigma_t$较小时,相比可训练的Embedding层,用固定的Sinusoidal编码来表示$t$所生成图片的噪声要更小;

5、在$\sigma_t$较小时,原论文的U-Net架构(Github中的ddpm2.py)要比笔者自行构思的U-Net架构(Github中的ddpm.py)所生成图片的噪声要更小;

6、但个人感觉,总体来说不带噪声的生成过程的生成效果不如带噪声的生成过程,不带噪声时生成效果受模型架构影响较大。

此外,对于$\sigma_t=0$时的DDIM,它就是将任意正态噪声向量变换为图片的一个确定性变换,这已经跟GAN几乎一致了,所以跟GAN类似,我们可以对噪声向量进行插值,然后观察对应的生成效果。但要注意的是,DDPM或DDIM对噪声分布都比较敏感,所以我们不能用线性插值而要用球面插值,因为由正态分布的叠加性,如果$\boldsymbol{z}_1,\boldsymbol{z}_2\sim\mathcal{N}(\boldsymbol{0}, \boldsymbol{I})$,$\lambda\boldsymbol{z}_1 + (1-\lambda)\boldsymbol{z}_2$一般就不服从$\mathcal{N}(\boldsymbol{0}, \boldsymbol{I})$,要改为

\begin{equation}\boldsymbol{z} = \boldsymbol{z}_1 \cos\frac{\lambda\pi}{2} + \boldsymbol{z}_2 \sin\frac{\lambda\pi}{2},\quad \lambda\in[0, 1]\end{equation}

插值效果演示(笔者自己训练的模型):

微分方程 #

最后,我们来重点分析一下$\sigma_t = 0$的情形。此时$\eqref{eq:sigma=0}$可以等价地改写成:

\begin{equation}\frac{\boldsymbol{x}_t}{\bar{\alpha}_t} - \frac{\boldsymbol{x}_{t-1}}{\bar{\alpha}_{t-1}} = \left(\frac{\bar{\beta}_t}{\bar{\alpha}_t} - \frac{\bar{\beta}_{t-1}}{\bar{\alpha}_{t-1}}\right) \boldsymbol{\epsilon}_{\boldsymbol{\theta}}(\boldsymbol{x}_t, t)\end{equation}

当$T$足够大,或者说$\alpha_t$与$\alpha_{t-1}$足够小时,我们可以将上式视为某个常微分方程的差分形式。特别地,引入虚拟的时间参数$s$,我们得到

\begin{equation}\frac{d}{ds}\left(\frac{\boldsymbol{x}(s)}{\bar{\alpha}(s)}\right) = \boldsymbol{\epsilon}_{\boldsymbol{\theta}}\left(\boldsymbol{x}(s), t(s)\right)\frac{d}{ds}\left(\frac{\bar{\beta}(s)}{\bar{\alpha}(s)}\right)\label{eq:ode}\end{equation}

不失一般性,假设$s\in[0,1]$,其中$s=0$对应$t=0$、$s=1$对应$t=T$。注意DDIM原论文直接用$\frac{\bar{\beta}(s)}{\bar{\alpha}(s)}$作为虚拟时间参数,这原则上是不大适合的,因为它的范围是$[0,\infty)$,无界的区间不利于数值求解。

那么现在我们要做的事情就是在给定$\boldsymbol{x}(1)\sim \mathcal{N}(\boldsymbol{0},\boldsymbol{I})$的情况下,去求解出$\boldsymbol{x}(0)$。而DDPM或者DDIM的迭代过程,对应于该常微分方程的欧拉方法。众所周知欧拉法的效率相对来说是最慢的,如果要想加速求解,可以用Heun方法、R-K方法等。也就是说,将生成过程等同于求解常微分方程后,可以借助常微分方程的数值解法,为生成过程的加速提供更丰富多样的手段。

以DDPM的默认参数$T=1000$、$\alpha_t = \sqrt{1 - \frac{0.02t}{T}}$为例,我们重复《生成扩散模型漫谈(一):DDPM = 拆楼 + 建楼》所做的估计

\begin{equation}\log \bar{\alpha}_t = \sum_{i=k}^t \log\alpha_k = \frac{1}{2} \sum_{k=1}^t \log\left(1 - \frac{0.02k}{T}\right) < \frac{1}{2} \sum_{k=1}^t \left(- \frac{0.02k}{T}\right) = -\frac{0.005t(t+1)}{T}\end{equation}

事实上,由于每个$\alpha_k$都很接近于1,所以上述估计其实也是一个很好的近似。而我们说了本文的出发点是$p(\boldsymbol{x}_t|\boldsymbol{x}_0)$,所以应该以$\bar{\alpha}_t$为起点,根据上述近似,我们可以直接简单地取

\begin{equation}\bar{\alpha}_t = \exp\left(-\frac{0.005t^2}{T}\right) = \exp\left(-\frac{5t^2}{T^2}\right)\end{equation}

如果取$s=t/T$为参数,那么正好$s\in[0,1]$,此时$\bar{\alpha}(s)=e^{-5s^2}$,代入到式$\eqref{eq:ode}$化简得

\begin{equation}\frac{d\boldsymbol{x}(s)}{ds} = 10s\left(\frac{\boldsymbol{\epsilon}_{\boldsymbol{\theta}}\left(\boldsymbol{x}(s), sT\right)}{\sqrt{1-e^{-10s^2}}} - \boldsymbol{x}(s)\right)\end{equation}

也可以取$s=t^2/T^2$为参数,此时也有$s\in[0,1]$,以及$\bar{\alpha}(s)=e^{-5s}$,代入到式$\eqref{eq:ode}$化简得

\begin{equation}\frac{d\boldsymbol{x}(s)}{ds} = 5\left(\frac{\boldsymbol{\epsilon}_{\boldsymbol{\theta}}\left(\boldsymbol{x}(s), \sqrt{s}T\right)}{\sqrt{1-e^{-10s}}} - \boldsymbol{x}(s)\right)\end{equation}

文章小结 #

本文接着上一篇DDPM的推导思路来介绍了DDIM,它重新审视了DDPM的出发点,去掉了推导过程中的$p(\boldsymbol{x}_t|\boldsymbol{x}_{t-1})$,从而获得了一簇更广泛的解和加速生成过程的思路,最后这簇新解还允许我们将生成过程跟常微分方程的求解联系起来,从而借助常微分方程的方法进一步对生成过程进行研究。

转载到请包括本文地址:https://spaces.ac.cn/archives/9181

更详细的转载事宜请参考:《科学空间FAQ》

如果您还有什么疑惑或建议,欢迎在下方评论区继续讨论。

如果您觉得本文还不错,欢迎分享/打赏本文。打赏并非要从中获得收益,而是希望知道科学空间获得了多少读者的真心关注。当然,如果你无视它,也不会影响你的阅读。再次表示欢迎和感谢!

如果您需要引用本文,请参考:

苏剑林. (Jul. 27, 2022). 《生成扩散模型漫谈(四):DDIM = 高观点DDPM 》[Blog post]. Retrieved from https://spaces.ac.cn/archives/9181

@online{kexuefm-9181,

title={生成扩散模型漫谈(四):DDIM = 高观点DDPM},

author={苏剑林},

year={2022},

month={Jul},

url={\url{https://spaces.ac.cn/archives/9181}},

}

January 4th, 2023

大佬 请教您一个问题:我们知道扩散模型在训练的时候会random一个时间步t,然后进行前向扩散,在逆向扩散的时候,会逐步地去除前向扩散时加入的高斯噪声。我有一个疑惑,就是按照上面所说的那种训练方式(假设加入噪声顺序为a-b-c-d-...,则去除顺序为...-d-c-b-a),训练完成后,在推理过程中,此时给出一个带噪图像(加入的噪声为b-a-d-c-...,即加入噪声与训练时的噪声顺序不同,或者噪声类别不同),此时网络推理结果是不是会很差,换言之是不是扩散模型就无法work了?

是的,必须训练预测一致。

感谢苏神的回答。那这么说的话,扩散模型的应用岂不是很局限?因为它只能去除掉在训练阶段中见到过的噪声,而且对加入的噪声顺序也有要求(如训练过噪声顺序为abcde(字母代表所加噪声)...,但没有训练过bcaed...)。也就是说在训练完成后,拿一个没有在训练过程中见过的加噪顺序(如bcaed...)的带噪图像,输入到训练好的扩散模型中进行推理,此时的扩散模型就不能正确去除噪声了...所以如果要让扩散模型能够work,就必须让它训练足够多的加噪情况,可是对于扩散模型来讲,想要结果不错,一般时间步t都是比较大的(比如1000,2000...等),此时的加噪顺序的可能性就非常非常多...不知道我的理解是否有误,期待苏神解答!

DDPM之类的扩散模型,是为了做生成模型,不是专门为了去噪,我们不需要它对去噪有多强大的能力呀。

嗷嗷,那为什么它会有强大的生成能力呢?我还是有点不太明白它能work的原因。我先讲一下我个人的理解:在训练阶段,扩散模型训练的参数其实就是Unet的参数,而Unet是拿来预测前向扩散的噪声的,每一次训练,Unet就会学习到一种去噪参数。当模型训练结束时,是否就意味着扩散模型学习到了多种去除训练过程中所添加的不同噪声的能力。在测试时,给定一个带噪图像输入到扩散模型中,它是否就是会根据在训练过程中所学到的去噪能力进行一个去噪过程呢?如果是这样的话,它怎么会生成同分布的新数据样本呢?而不应该是生成出来训练时输入的数据样本吗?还有一个问题就是,为什么类似DDPM这类扩散模型都是添加高斯噪声呢,只是因为高斯噪声容易表示吗?我的提问可能比较繁杂,十分感谢苏神的解惑!

热心网友试着回答下,真理还得看苏神。

DDPM去噪的过程也是具有随机性的(X_T以及每一步的reverse都具有随机性),所以不会只生成输入的样本。不仅仅是高斯噪声,可以是别的变换,已经有相关文献可以参考,好像叫cold diffsuion。通过公式推导可以发现,去噪只是表象,本质上是为了学习数据分布,所以可以作为一个生成式模型去产生新样本。

嗷嗷,十分感谢!

你在这篇文章下提问,我不知道你想要什么样的回答。生硬一点,就是理论推导出来,这样训练好之后、按照它设计的步骤采样就是一个生成模型,不要问为什么,问就是去推公式;通俗一点,第一篇“拆楼+建楼”已经很通俗了,噪声相当于原材料,模拟的是一步步建楼的过程,你在第四篇评论,不至于没看过第一篇吧,看了第一篇还有这个疑惑,这让我也感觉很疑惑。

推理的时候要告诉t的,这个相当于告诉模型当前图片噪声的含量,你这个操作相当于把t乱给了,当然不行。

January 10th, 2023

“具体来说,设τ=[τ1,τ2,…,τdim(τ)]是[1,2,⋯,T]的任意子序列,那么我们以α¯τ1,α¯τ2,⋯,α¯dim(τ)为参数训练一个扩散步数为dim(τ)步的DDPM,其目标函数实际上是原来以α¯1,α¯2,⋯,α¯T的T步DDPM的目标函数的一个子集!所以在模型拟合能力足够好的情况下,它其实包含了任意子序列参数的训练结果。”

苏神,这个任意子序列中序列顺序也可以是任意的吗?

子序列,不是子集。

January 13th, 2023

明白了,谢谢苏神。

January 19th, 2023

站长好,请教您一个问题:您在扩散模型漫谈(一)中的式(16)也是一个确定性变换。您当时在那篇文章中指出确定性变换对应于Greedy Search,而有噪声的解码过程对应于Random Sample。那么我们是否也可以理解为相比于DDPM,DDIM就是一个所谓的Greedy Search方法呢?其和扩散模型漫谈(一)中的式(16)是否是对应的呢?

不对应。DDPM是原本(理论上)有噪声,所谓greedy search只是强行去掉了噪声,实际效果通常很差;DDIM是理论上就没有噪声,不加噪声的效果也很好。

February 23rd, 2023

问个可能很愚蠢的问题:

σt=β¯t−1βt/β¯t

这个横线不是连乘的意思嘛?如果是的话,那不是可以直接化简成1吗?

$$\bar{\alpha}_t = \alpha_1\alpha_2\cdots\alpha_t,\quad\bar{\beta}_t=\sqrt{1-\bar{\alpha}_t^2}$$

这些在第一篇都定义得很清楚。

懂啦谢谢苏神!

求问这个是不是等于1啊,如果等于1的话$\sqrt{\bar{\beta}_{t-1}^2 - \sigma_t^2} = \sqrt{\bar{\beta}_{t-1}^2 - 1}$,考虑到$0 < \bar{\beta}_{t-1}^2 < 1$这个根号下面不是就是负数了吗

$\sigma_t$为什么会等于1?

March 7th, 2023

苏神好!我想问一下式$(2)$在ddim下也成立吗?因为只根据贝叶斯的话,右边分子$p(x_t|x_{t−1})$应该还有一个条件$x_0$,式$(2)$是在ddpm的马尔可夫假设下才把$x_0$去掉,但是ddim认为是更加一般性的情况,那这时候如何引出后面的“$p(x_{t−1}|x_t,x_0)$是一个正态分布”并且进行待定系数法求解均值和方差的呢?

感觉这种方式又当它是马尔可夫(把$x_0$的条件去掉),然后又当他是一般化的形式,有点怪怪的。初学diffusion,哪里有理解错误请苏神多多包涵指点!

不成立。一般地有

$$p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t, \boldsymbol{x}_0) = \frac{p(\boldsymbol{x}_t|\boldsymbol{x}_{t-1},\boldsymbol{x}_0)p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_0)}{p(\boldsymbol{x}_t|\boldsymbol{x}_0)}$$

只是在DDPM中恰好有

$$p(\boldsymbol{x}_t|\boldsymbol{x}_{t-1},\boldsymbol{x}_0)=p(\boldsymbol{x}_t|\boldsymbol{x}_{t-1})$$

DDIM是重新寻找了更一般的$p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t, \boldsymbol{x}_0)$,那么对应的$p(\boldsymbol{x}_t|\boldsymbol{x}_{t-1},\boldsymbol{x}_0)$自然也会被更新。

既然在DDIM中$p(x_t|x_{t-1},x_0)=p(x_t|x_{t-1})$不能成立,那么如何证明这时候$p(x_t|x_{t-1},x_0)$为正态分布呢?上一节的证明是用$p(x_t|x_{t-1})$的表达式代入来证明的,但是这时候$p(x_t|x_{t-1},x_0)$并没有一个具体的表达式

DDIM没有显式用到“$p(\boldsymbol{x}_t|\boldsymbol{x}_{t-1},\boldsymbol{x}_0)$是正态分布这个结论“,DDIM只是在给定$p(\boldsymbol{x}_t|\boldsymbol{x}_0)$和$p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_0)$的前提下,用待定系数法求出了一个$p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t,\boldsymbol{x}_0)$。

如果你比较关心$p(\boldsymbol{x}_t|\boldsymbol{x}_{t-1},\boldsymbol{x}_0)$,那么可以在确定$p(\boldsymbol{x}_{t-1}|\boldsymbol{x}_t,\boldsymbol{x}_0)$后,反过来用贝叶斯公式求。

$p(x_{t−1}|x_t,x_0)$为什么也是一个正态分布呢,看起来像是用待定系数法先确定了一个未知参数的正态分布

是我们假设它是正态分布,然后求出一组解,不排除它还有非正态分布的解。

至于为什么可以假设它是正态分布,这是因为DDPM的$p(\boldsymbol{x}_{t−1}|\boldsymbol{x}_t,\boldsymbol{x}_0)$就是一个正态分布,所以我们设正态分布它一定会有解,我们希望能求出比DDPM更一般的解。

March 16th, 2023

苏神好,我发现不考虑公式只考虑结构,从迭代去噪的角度去逼近DDPM的结论是个很有趣的过程:因为nn去除噪声的一部分比去除所有噪声再加噪还难(DIP和频率原则),所以要先预估$x_0$再加噪效果才能好;因为一次去噪可能产生过模糊的结果,所以要用预估-修正的思路去迭代处理(deep unrolling那边更可解释)。

然而在逼近过程中我有了一个困惑——这个过程好像并不是马尔科夫链了啊?一方面,正向过程$q(x_{t}|x_{t-1})$就是个构造,实际上完全没用上啊(同【高观点1】,只用$q(x_{t}|x_0)$),DDPM的逆向生成过程$p(x_{t-1}|x_t)$中去噪后用的加噪一直是一步到位的高斯分布$\sigma_t^2 z, z\sim \mathcal N(0,1)$。另一方面,逆向生成过程中每一次的$z\sim \mathcal N(0,1)$都是一个独立的采样,那$x_{t-1}$和$x_t$的噪声项似乎就是独立的了,这还能算马尔科夫链么?

我不知道我哪里想岔了,还请苏神有空的话帮忙指正一下,感激不尽。

逆向过程中,$\boldsymbol{x}_{t-1}$和$\boldsymbol{x}_t$的噪声是独立的,但是$\boldsymbol{x}_{t-1}$还是跟$\boldsymbol{x}_t$有关的,并且只依赖于$\boldsymbol{x}_t$(以及完全独立的噪声),这种特性的就是马尔科夫链呀。

March 19th, 2023

thanks,我明白了,是我太执着于和DDPM论文前面提到的正向过程完全对应了

April 6th, 2023

问大佬一个简单的问题,DDIM这一类的加速采样的方法是否能够降低训练成本,我看很多都是采用的DDPM原有的预训练模型,只是加速了推理过程,有没有通过加速采样来降低训练成本的这种尝试呢

减少采样$t$或许可以降低训练成本(比如$t\in[0,1,\cdots,999]$改为$t\in[0, 10, \cdots, 990]$)

April 21st, 2023

感谢苏神,我不知道如果没有你这篇文章我得花几百倍的时间才能看懂DDIM,至上敬意,然后我说说看完这篇文章之后的理解,当Xt-1与Xt成线性关系,就是说Xt-1的克瑟和Xt的克瑟1是完全相同的,从DDPM的角度看这是荒谬和绝对错误的,但DDIM揭示了,DDPM从一个有物理渊源的(思考方式/模型)出发得出了一个不错的结果,但本质里面work的部分只是“每次预测一次X0,但只更新接近它一点点”这个简单的approach

祝贺。